-

湖泊是地球上重要的淡水资源之一,许多地区都依赖湖泊作为主要饮水来源[1-2]。然而,工业废水和城市生活污水不加节制的排放,导致湖泊水体严重富营养化,引发藻类快速繁殖[3-5],并造成湖泊滨岸带蓝藻水华堆积,严重影响用水安全,破坏水域生态平衡[6]。因此,实时定量监测湖泊滨岸带蓝藻水华,获取蓝藻水华的空间分布与动态变化,对于湖泊生态环境治理具有重要意义。

目前,监测湖泊蓝藻水华的主要方法包括人工监测[7-9]、卫星遥感监测[10-13]以及视频监测[14]。人工采样监测能够了解湖泊生态系统信息,但蓝藻繁殖迅速[15],该方法存在采样不均匀、样本数量有限以及分析周期长等问题[16-18]。卫星遥感监测因其覆盖范围广且能够提供高精度数据等优势,已被国内外专家广泛应用于湖泊蓝藻水华监测,但受制于运行轨道和监测水域上方的云层遮盖影响,致使其无法实现对特定水域的蓝藻水华实时监测,从而导致监测结果存在一定的限制[19]。针对人工监测、卫星遥感监测方法存在的弊端,视频监控技术凭借自动化与实时性等特点,为湖泊滨岸带蓝藻水华监测提供了新思路。例如,邱银国等[20]整合卫星遥感、视频监控等手段,构建了巢湖水质和蓝藻水华的全方面监测;马腾耀等[21]基于视频监控动态监测湖泊沿岸蓝藻水华的覆盖率;LIU等[22]利用双目立体视觉原理实现目标水域的三维重建,并对水域图像进行蓝藻水华提取。

然而,目前视频监控监测方法所能提供的仅仅是蓝藻水华所占比例,而非准确的面积数据,这种基于比例的监测数据存在明显的不确定性,在实践应用中存在较大风险。例如,对于同一片蓝藻水域,随着视频监控设备拍摄角度的变化,蓝藻水华面积占比可能出现截然不同的结果。因此,通过对摄像头针孔模型的深入研究,提出一种基于视频监控图像的蓝藻水华实时定量监测方法,为湖泊水环境管理人员提供湖泊滨岸带水域中蓝藻水华的实际覆盖面积及其演变趋势,为科学研究和管理决策提供可靠的数据支持。

-

巢湖 (31°25'28''~31°43'28'' N,117°16'54''~117°51'46" E) 位于中国安徽省中部,是我国五大淡水湖之一。巢湖总面积约775 km2,东西长约61 km,南北宽约21 km,平均水深2.89 m[23]。巢湖周围环绕着包河、肥东、巢湖、无为、庐江、肥西等城市 (图1) ,湖水主要依赖地面径流进行补给,沿湖地区共有33条河流流入巢湖[24]。巢湖流域位于北亚热带湿润季风气候区,气候温和宜人,年平均水温约为16 ℃,流域的降水主要集中在夏季和秋季[25]。随着巢湖周边城市工业化和城镇化的快速推进,各种工业和生活废水都排放至巢湖,导致巢湖水体富营养化问题日益加剧,造成湖泊滨岸带蓝藻水华堆积严重,严重影响湖泊生态环境,给当地居民的饮用水安全带来巨大的挑战[26]。

-

本研究采用的图像数据来自环巢湖的42台视频监控摄像头。这些摄像头以岸基方式沿岸部署,并通过网络传送画面至视频监控中心。此外,视频监控中心能够获取摄像头的内外参数信息,并具备摄像头视角P (Pan,水平) 、T (Tilt,俯仰) 和Z (Zoom,缩放) 属性的控制能力,确保所捕捉画面专注于湖泊滨岸带水域水质情况,从而避免其他区域的干扰。鉴于夜间环境能见度低,对蓝藻水华图像采集时间进行优化,将视频监控采集图像时间段设定在早上8点至下午6点之间,每小时进行1次现场采集,对于蓝藻水华暴发较为频繁的视频监控站点,采取每隔30 min进行图像采集,在2021年6月至2021年10月期间从42台视频监控摄像头中共获取1 847张有效图像。

-

卷积神经网络 (Convolutional Neural Network, CNN) 是深度学习中最常用的模型之一,其核心思想是通过卷积操作和池化操作来提取数据的局部特征,并通过多层卷积层和全连接层实现特征的组合和分类[27]。CNN在图像分类、目标检测、图像分割等领域取得了巨大的成功[28]。

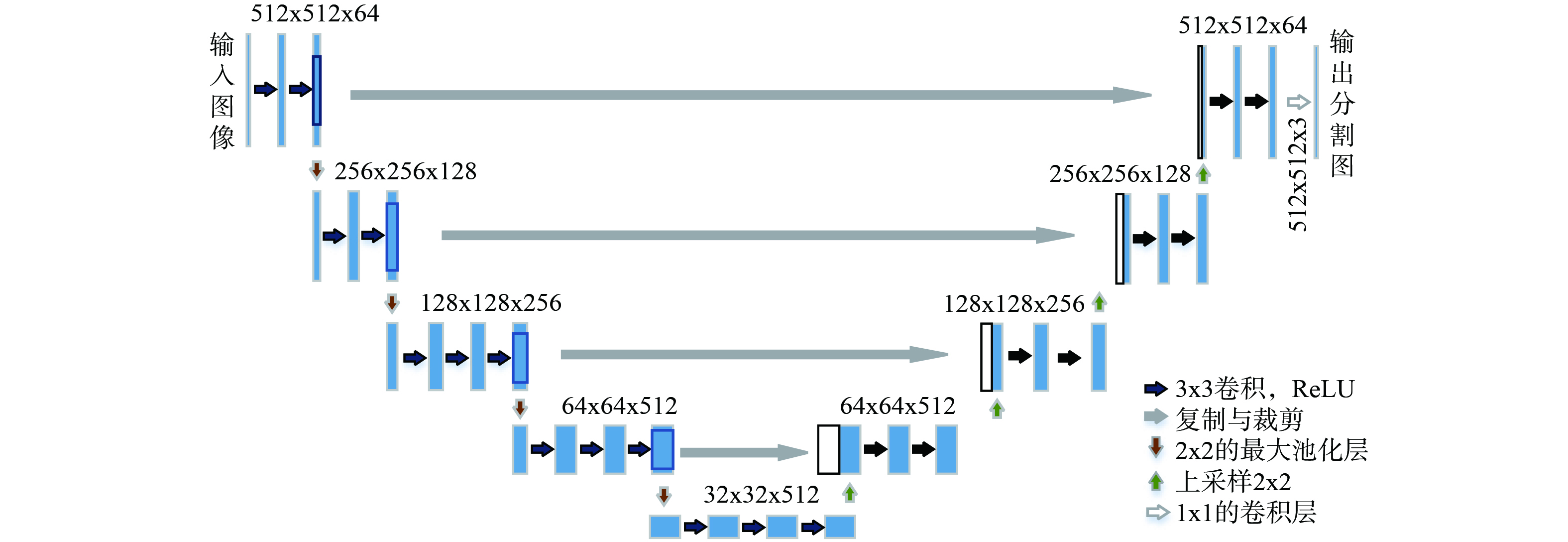

UNet是一种用于图像分割的卷积神经网络架构[29]。UNet的架构由一个对称的编码器-解码器结构组成,编码器部分对特征图进行特征提取,解码器部分负责恢复至原始图像大小,并逐像素点分类。其中UNet还引入跳跃连接,将编码器中的特征图与解码器中的对应特征图进行连接,提高分割结果的细节和准确性[30]。VGG16网络主要由13个卷积层和3个全连接层组成[31]。与UNet的特征提取部分相比,VGG16网络多出3个卷积层,并引入了3次ReLU激活操作,这一选择赋予VGG16网络更大的感受野和更强的特征提取能力,使VGG16网络能够更好地捕捉图像中复杂的特征。相比之下,UNet的编码器部分则较浅,可能无法充分捕捉图像中更复杂的图像特征。因此,采用VGG16网络作为UNet的特征提取部分 (图2) ,能够更有效地提升图像分割的精确度。

DeepLabV3+模型由Chen等提出的基于编码器-解码器结构的CNN模型[32],其编码器部分采用Xception网络或者轻量级Mobilenetv2作为主干网络,同时引入空洞卷积的空间金字塔池化模块,增强感受野面积,该设计使得DeepLabV3+能够有效识别出不同空间尺寸的物体[33]。

由于UNet和DeepLabV3+模型都在图像分割领域表现优秀,因此选取这两个模型进行比较。

-

摄像头捕捉的图像是对三维世界的二维展示,其中图像由像素点组成[34-35]。将湖泊水面视为一个水平平面,并将摄像头的镜头视为光学中心,基于针孔模型原理,结合内外参数,计算图像中每个像素点对应的实际平面区域面积,最后统计蓝藻水华像素,计算出摄像头所捕捉图像中蓝藻水华的实际面积。

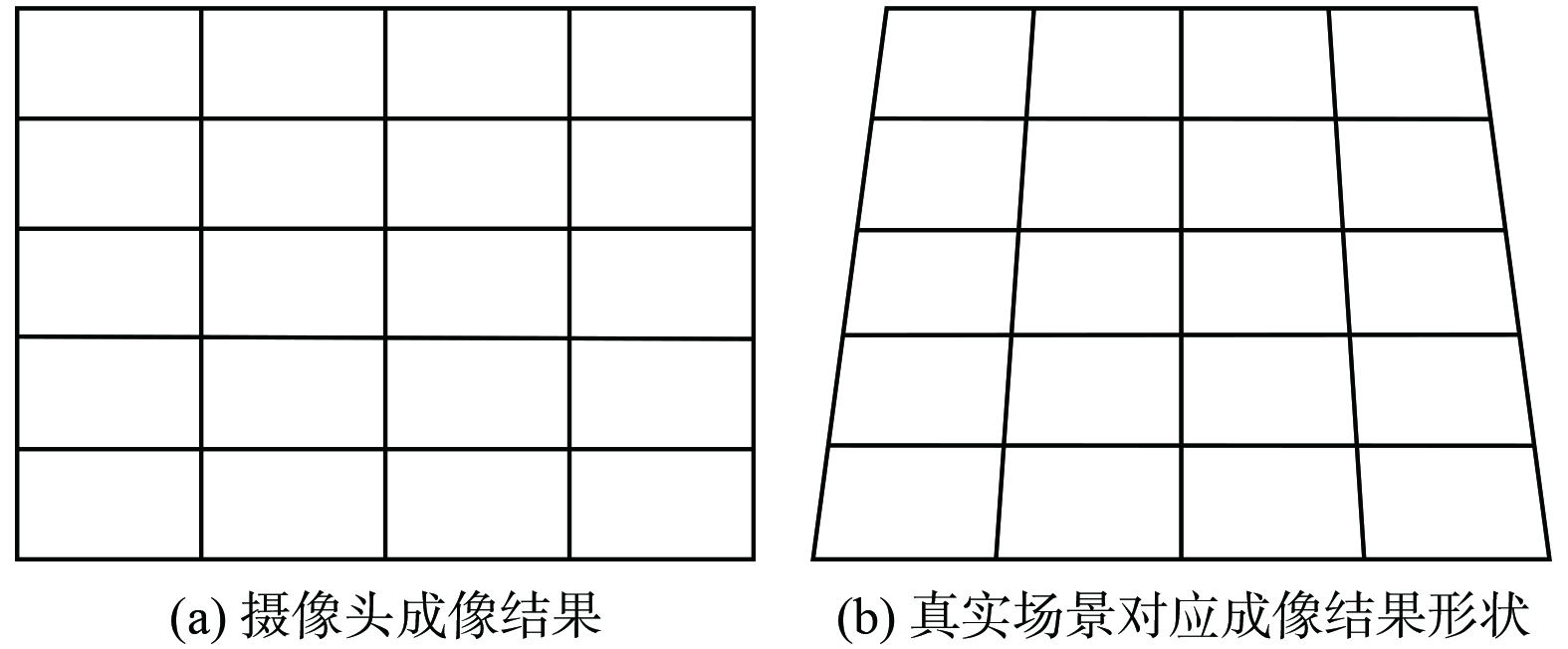

基于摄像头的成像原理,尽管图像呈现为矩形 (图3(a)) ,然而由于拍摄视野的角度,摄像头的视线会向外扩展,从而导致图像所呈现的应是真实场景梯形范围[36] (图3(b)) 。因此,为了精确计算图像中每个像素所对应的实际平面区域,就需要确定每个小梯形的高度以及底边长。

1) 求解梯形的高。基于摄像头的针孔模型侧视图如图4所示,找到对应的相似三角形关系,通过连续推导与递推的方法,求解每行梯形的高度。

求解单像素B'E'所代表的梯形的高,其计算公式如式(1)所示。

根据三角形相似计算得到∠B'AE',其计算公式如见式(5)所示。

式中:AB为摄像头垂直视场角射线长度,m;BE为像素所对应梯形的高,m;∠AEB为单像素B'E'对应远视场线与水平方向的夹角;∠BAE为单像素B'E'对应的视场角;h为摄像头距离湖泊水面高度,m;∠oAC为摄像头中心视线与竖直方向的夹角;B'C'为摄像头的成像模块的宽,m;f为摄像头焦距,m;∠B'AE'为单像素B'E'对应的视场角;B'E'为单像素宽,m;AB'为光心到单像素B'E'顶部的距离,m;∠B'为光轴线与成像模块之间的夹角;AE'为光心到单像素B'E'底部的距离,m。

通过视频监控中心获取摄像头的内外参数数据 (视场角角度,成像模块尺寸,图像分辨率,焦距,单像素尺寸,摄像头距离水平面高) ,将其代入针孔模型的相关公式,计算出像素B'E'所对应高BE。同理,通过累加像素,逐步推导出每一层像素所对应的角度大小,从而计算出梯形中每一层梯形的高度。

2) 求解梯形上下底长度。基于摄像头针孔模型画出俯视图如图5所示,根据相似三角形原理,计算梯形中最长与最短底边长,并通过递推得到每一层底的长度。

求解出梯形中最长与最短底边的长度,其计算公式如式 (9) 所示。

式中:M'N'为摄像头成像模块的长,m;MN为真实场景梯形状的底边长,m;AB为摄像头垂直视场角射线长,m;f为摄像头焦距,m;∠B'Ab为主光轴与AB'的夹角。

如图6所示,通过绘制辅助线M1P,利用几何关系,可以确定∠M2的大小。然后做最长底梯形的垂线N3Q,利用该行梯形的高以及∠N2的大小,计算出该行梯形上底长。通过递推依次计算出每一行梯形的底边长,再将每行梯形底边长度除以每行的像素个数,从而得到每个像素小梯形的底边长度。

3) 求解梯形面积。结合该梯形的上下底以及高,计算出蓝藻水华像素所对应的梯形面积。

根据梯形面积计算公式,代入已求得的高BE,以及该行梯形的上下底长,即可求出单像素B'E'所代表的梯形面积,其计算公式如式 (11) 所示。同理,图像中蓝藻水华的实际总面积可通过蓝藻水华像素所对应的梯形面积累加求得。

式中:M1M12为单像素对应梯形的上底,m;M3M32为单像素对应梯形的下底,m;S为所求蓝藻水华像素对应的面积,m2。

-

交并比 (Intersection over Union,IoU) 是模型对每一类的预测值与真实值之间的交集与并集的比值。而平均交并比 (mean-IoU,mIoU) 是计算每个类别中IoU值的平均值,是语义分割的标准度量[37]。平均交并比计算公式如式(12)所示。

式中:mIoU为平均交并比值;k为总类别数;Pii为第i类并预测为i类的像素点总数;Pij为第i类却被预测为j类的像素点总数;Pji为第j类却被预测为i类的像素点总数。

总体精度(Overall Accuracy, OA)为被正确分类的样本个数占样本总数的比例[37], 其计算公式如式(13)所示。

式中:OA为总体精度;N为样本总量;r为分类类别总个数;Xii为每类中正确分类样本的数量。

-

实验将采集得到的1 847张蓝藻水华图像,按照9∶1的比例对图像数据集进行划分,随机选取1 662张作为训练集,剩余185张作为测试集。使用LabelMe软件对图像中的蓝藻水华像素进行类别和位置标记,生成与图像对应的json格式标签文件[38]。采用裁剪和旋转等图像增强方式,扩充数据集的样本数量,提高网络模型的稳定性和泛化性能,从而增强了蓝藻水华像素识别的准确性和鲁棒性。

本研究使用Python编程语言在深度学习框架Pytorch下进行模型开发,并基于VGG16-UNet模型进行蓝藻水华像素识别,采用了Adam优化器,初始学习率设置为0.001,并将训练的Epoch设定为100,以确保模型参数能够更稳定地更新,从而提升训练效果[39]。

-

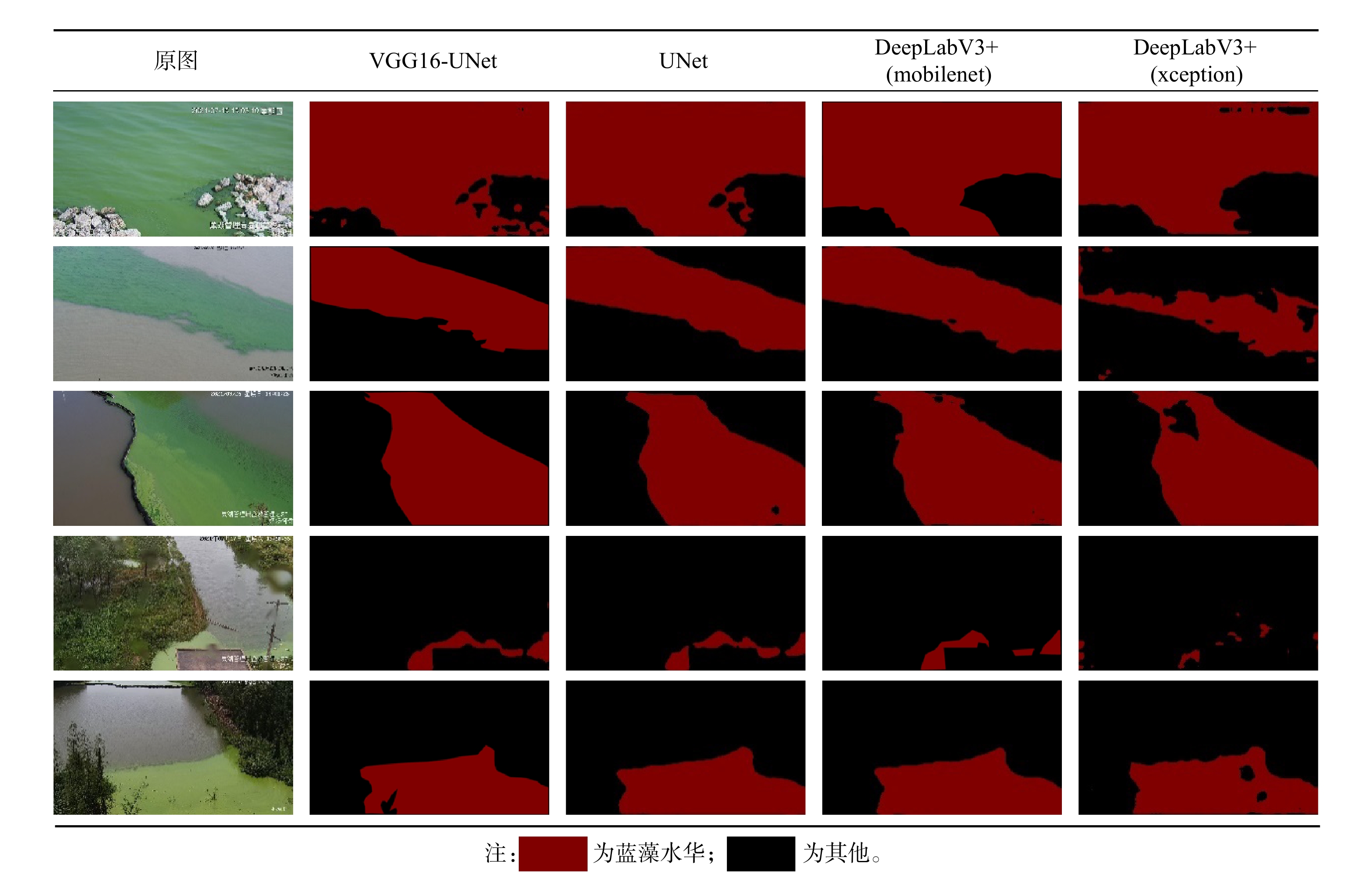

在模型训练过程中,主要侧重于评估两个关键的指标,即mIoU和OA。不同模型的分割结果见表1。通过分析表1中的数据,可以观察到:UNet模型在mIoU和OA指标上整体表现略优于DeeplabV3+模型;此外,VGG16-UNet模型的精度指标略高于传统UNet模型。此评价结果为后续深入分析和实际应用提供了保障。

本研究在不同模型下对蓝藻水华图像进行蓝藻水华像素识别,不同模型的蓝藻水华像素识别结果如表2所示。从中可以看出,由于UNet模型架构简单,在中到小规模的分割任务中表现更好[40],所以能够更好分割出蓝藻水华像素;相比之下,DeepLabV3+模型分割的图像容易丢失部分蓝藻水华像素;另一方面,由于VGG16网络比传统UNet模型的特征提取部分多了3层卷积操作,能够更好地提取特征,所以在蓝藻水华像素不明显的地方,VGG16-UNet模型能够更有效地分割出蓝藻水华细节区域。

-

对摄像头捕获的一幅图像进行蓝藻水华像素识别 (见表3) ,通过视频监控中心获取该摄像头距离湖泊平面高约为13 m,俯仰角为64度,焦距为8 mm,倍距为1,将参数输入蓝藻水华定量监测模型,计算得到该幅图像中蓝藻水华面积约为43.07 m2。

-

由于监控所拍摄的画面被设定在湖泊滨岸带周边,因此所拍摄范围相对较小。借助无人机拍摄监测区域,对计算结果进行精度验证。测量前,首先对无人机校准和测试,以确保结果的准确性,将无人机悬停在目标水域上方,使用无人机移动设备上的应用程序,打开面积测量功能,标记出测量区域的边界,无人机系统则自动计算出该区域的面积,并显示在屏幕上。通过实地操控无人机并记录相关数据,得到表3中的蓝藻水华面积约为46.53 m2,在本实验中通过针孔模型计算出来的蓝藻水华面积约为43.07 m2,计算值与实测值之间的相对误差约为7.4%。

为了确保实验结果可靠,选取蓝藻水华发生较为频繁的5个视频监控站点,并从每个站点获取20张蓝藻水华图像,共计100图像进行蓝藻水华像素识别,计算每幅图像的蓝藻水华面积,并绘制蓝藻水华面积计算值与实测值的散点图 (图8) 。如图8所示,蓝藻水华面积计算值与实测值线性关系良好,其线性拟合斜率为0.89,拟合系数R2为0.97,平均相对误差MRE为11.25%。从图8可以看出,蓝藻水华面积范围在0~50 m2内,模型计算值与实测值误差较小,拟合程度较好;当蓝藻水华暴发严重时,即蓝藻水华面积大于100 m2,由于拍摄视野范围变大,就会导致部分计算值与实测值产生较高误差。

-

通过设定自动化蓝藻水华定量监测程序,选取2021年6月至2021年10月期间巢湖视频监控“李郢村”站点 (图9) 所拍摄的图像进行蓝藻水华像素识别以及定量监测。

2021年6至10月“李郢村”站点视频监控观测的日均蓝藻水华面积变化趋势图如图10所示。 2021年6月,该视频监控站点拍摄到蓝藻水华现象,在7月至10月期间,该区域共经历了2次蓝藻水华的暴发,严重时蓝藻水华覆盖面积高达267 m2。不过,由于管理措施的及时介入,蓝藻水华覆盖面积得以显著改善,8月蓝藻水华覆盖面积基本控制在100 m2以内。然而,9月持续高温,导致蓝藻水华大面积暴发。10月气温降低,蓝藻水华覆盖面积也逐渐降低。这一变化突显蓝藻水华的演化过程极为迅速,以及实时定量监测和管理在应对蓝藻水华问题中的关键作用。

-

1) 通过对比不同蓝藻水华像素识别算法的效果,最后采用VGG16-UNet模型实现对蓝藻水华像素识别,该模型的平均交并比与总体精度分别达到了88.74%与94.10%,表明所采用的模型在捕捉蓝藻水华区域的同时,能够准确地识别像素级的细节,为湖泊蓝藻水华识别提供了精准的方法。

2) 基于摄像头针孔模型的蓝藻水华定量监测结果,与实测值具有良好的拟合度,拟合系数R2为0.97,表明该方法能够准确计算出水体中蓝藻水华的实际覆盖面积,为湖泊水环境管理人员提供了一种可靠的湖泊滨岸带蓝藻水华定量监测方法,对于湖泊水质管理具有重要意义。

3) 基于视频监控的湖泊滨岸带蓝藻水华实时定量监测方法,能够实时捕获蓝藻水华的空间分布以及动态变化过程,有助于确定蓝藻水华的易暴发区域。且长期的监测数据,可作为湖泊蓝藻水华监测研究的数据支撑。此外,依靠设定自动化程序,生成可视化数据,使湖泊水环境管理人员能够掌握湖泊滨岸带蓝藻水华的实际分布情况,有助于减轻巡查任务。

4) 实时视频监控技术在湖泊滨岸带蓝藻水华的定量监测方面展现出显著的潜力,能够准确计算所拍摄图像中蓝藻水华的覆盖面积。然而,受到监测设备视野范围的限制,此技术仅限于拍摄近岸水域,无法清晰捕捉超出湖泊滨岸水域范围的情况,因此未来的研究将专注于提升监测方法的精度、监测范围以及提高操作性。同时,结合“天-空-地”协同观测技术,以更好地了解并管理湖泊蓝藻水华,保护水资源和生态系统。

基于视频监控的湖泊滨岸带蓝藻水华实时定量监测方法及应用研究

Real-time quantitative monitoring method of cyanobacterial blooms in lake riparian zones based on video surveillance and application research

-

摘要: 湖泊作为我国主要饮用水源地,其滨岸带蓝藻水华过度堆积,对用水安全以及生态环境造成严重影响。因此,实时定量监测湖泊滨岸带蓝藻水华,是湖泊蓝藻水华防控的关键举措。基于环湖实时视频监控所捕获的水域图像,采用深度学习方法识别蓝藻水华像素,并根据摄像头成像原理及内外参数准确计算每个蓝藻水华像素对应实际蓝藻水华面积,最后统计分析湖泊滨岸带水域的蓝藻水华总面积。实验结果表明,基于VGG16-UNet模型的蓝藻水华像素识别方法的平均交并比与总体精度分别达到了88.74%与94.10%,优于同类方法;且蓝藻水华面积计算值与实测值具有良好的拟合度 (R2=0.97) 。该方法能够及时获取湖泊滨岸带蓝藻水华的覆盖面积及其动态变化过程,对于湖泊水环境治理起着重要作用。Abstract: Excessive accumulation of cyanobacterial blooms in the riparian zones of lakes, which are the main source of drinking water, has a serious impact on water safety as well as on the ecological environment. Therefore, real-time quantitative monitoring of cyanobacterial blooms in lake riparian zones is a key initiative for the prevention and control of cyanobacterial blooms in lakes. Based on the images of waters captured by real-time video surveillance around the lake, a deep learning method was used for cyanobacteria pixel recognition, and the actual cyanobacteria bloom area corresponding to each cyanobacteria pixel was accurately calculated according to the camera imaging principle and internal and external parameters, and finally the total area of cyanobacteria bloom in the waters of the lake’s riparian zone was statistically analyzed. The experimental results showed that the average intersection ratio and overall accuracy of the cyanobacterial pixel identification method based on the VGG16-UNet model reached 88.74% and 94.10%, respectively, which was better than similar methods; and the calculated values of cyanobacterial bloom area had a good fit with the measured values (R2=0.97). This method enabled the timely acquisition of cyanobacterial bloom coverage and facilitates monitoring the dynamic changes along the riparian zones of lakes, playing a pivotal role in the management of lake water environments.

-

Key words:

- lake /

- eutrophication /

- cyanobacteria bloom /

- video surveillance /

- quantitative monitoring

-

-

表 1 不同模型分割结果

Table 1. Segmentation results of different models

模型 主干提取网络 mIoU/% OA/% 蓝藻水华IoU/% UNet — 81.26 89.75 76 UNet VGG16 88.74 94.10 86 DeeplabV3+ xception 71.8 82.61 64 DeeplabV3+ mobilenet 79.41 86.55 71 表 2 不同模型蓝藻水华像素识别结果

Table 2. Pixel identification results of cyanobacterial blooms with different models

表 3 视频监控图像与蓝藻水华像素识别图像

Table 3. Video surveillance images and cyanobacteria bloom segmentation image

-

[1] 张甘霖, 谷孝鸿, 赵涛, 等. 中国湖泊生态环境变化与保护对策[J]. 中国科学院院刊, 2023, 38(3): 358-364. [2] 张运林, 秦伯强, 朱广伟, 等. 论湖泊重要性及我国湖泊面临的主要生态环境问题[J]. 科学通报, 2022, 67(30): 3503-3519. [3] 张民, 孔繁翔. 巢湖富营养化的历程、空间分布与治理策略(1984-2013年)[J]. 湖泊科学, 2015, 27(5): 791-798. doi: 10.18307/2015.0505 [4] DZIALOWSKI A R, SMITH V H, HUGGINS D G, et al. Development of predictive models for geosmin-related taste and odor in Kansas, USA, drinking water reservoirs[J]. Water Research, 2009, 43(11): 2829-2840. doi: 10.1016/j.watres.2009.04.001 [5] 吴林锋, 朱云, 朱喜. 2007-2020年太湖蓝藻持续暴发影响因素分析[J]. 水资源开发与管理, 2023, 9(2): 43-49,84. [6] 宣淮翔, 安树青, 孙庆业, 等. 巢湖西半湖北岸湖滨带蓝藻堆积处细菌多样性初步研究[J]. 水产学报, 2011, 35(12): 1873-1880. [7] 国家环境保护总局. 水和废水监测分析方法[M]. 4版. 北京: 中国环境科学出版社, 2002. [8] 翁建中, 王亚超, 李继影, 等. 荧光技术在太湖蓝藻水华预警监测中的应用[J]. 中国环境监测, 2009, 25(4): 23-26. doi: 10.3969/j.issn.1002-6002.2009.04.007 [9] 周君薇, 张丽娟, 周宇昆, 等. 实时荧光定量PCR技术在太湖蓝藻监测和评估中的应用[J]. 生态毒理学报, 2021, 16(6): 13-25. doi: 10.7524/AJE.1673-5897.20210315002 [10] 朱雨新, 李云梅, 张玉, 等. 基于遥感反射率的太湖优势藻识别方法[J]. 湖泊科学, 2023, 35(1): 73-87. [11] GOWER J, HU C, BORSTAD G, et al. Ocean Color Satellites Show Extensive Lines of Floating Sargassum in the Gulf of Mexico[J]. IEEE Transactions on Geoscience and Remote Sensing, 2006, 44(12): 3619-3625. doi: 10.1109/TGRS.2006.882258 [12] 李旭文, 侍昊, 张悦, 等. 基于欧洲航天局“哨兵-2A”卫星的太湖蓝藻遥感监测[J]. 中国环境监测, 2018, 34(4): 169-176. [13] 徐良泉, 苏涛, 雷波等. 基于FAI-L方法的巢湖水域藻华提取方法研究[J]. 湖泊科学, 2023, 35(4): 1222-1235. doi: 10.18307/2023.0416 [14] 尹美琳, 张嘉琪, 路春晖, 等. 蓝藻实时监测技术综述[J]. 价值工程, 2019, 38(22): 208-209. [15] DAVID P, JOEEL R, JEAN-FRANCOIS H. Influence of sampling strategies on the monitoring of cyanobacteria in shallow lakes: Lessons from a case study in France[J]. Water Research, 2011, 45(3): 1005-1014. doi: 10.1016/j.watres.2010.10.011 [16] 钟声. 太湖蓝藻水华的自动监测和手工监测比对分析[J]. 环境监控与预警, 2021, 13(3): 19-23. doi: 10.3969/j.issn.1674-6732.2021.03.004 [17] BOWLING L, RYAN D, HOLLIDAY J, et al. Evaluation of in situ fluorometry to determine cyanobacterial abundance in the Murray and lower darling rivers, Australia[J]. River Research and Applications, 2013, 29(8): 1059-1070. doi: 10.1002/rra.2601 [18] BERTONE E, BURFORD A M, HAMILTON P D. Fluorescence probes for real-time remote cyanobacteria monitoring: A review of challenges and opportunities[J]. Water Research, 2018, 141(15): 152-162. [19] 王伟超, 邹维宝. 高分辨率遥感影像信息提取方法综述[J]. 北京测绘, 2013, 27(4): 1-5. doi: 10.3969/j.issn.1007-3000.2013.04.001 [20] 邱银国, 段洪涛, 万能胜, 等. 巢湖蓝藻水华监测预警与模拟分析平台设计与实践[J]. 湖泊科学, 2022, 34(1): 38-48. doi: 10.18307/2022.0102 [21] 马腾耀, 肖鹏峰, 张学良, 等. 基于视频监控图像的环巢湖蓝藻实时动态监测[J]. 湖泊科学, 2022, 34(6): 1840-1853. doi: 10.18307/2022.0605 [22] LIU J, XIA C L, XIE H, et al. Accurate monitoring of algal blooms in key nearshore zones of lakes and reservoirs using binocular video surveillance system[J]. Water, 2022, 14(22): 3728. doi: 10.3390/w14223728 [23] ZHANG M, ZHANG Y, YANG Z, et al. Spatial and seasonal shifts in bloom‐forming cyanobacteria in Lake Chaohu: Patterns and driving factors[J]. Phycological Research, 2016, 64(1): 44-55. doi: 10.1111/pre.12112 [24] 王徐林, 张民, 殷进. 巢湖浮游藻类功能群的组成特性及其影响因素[J]. 湖泊科学, 2018, 30(2): 431-440. doi: 10.18307/2018.0214 [25] 陈实, 高超, 黄银兰. 不同季节划分尺度下巢湖流域气候变化趋势分析[J]. 长江流域资源与环境, 2013, 22(5): 582-587. [26] 钱瑞, 彭福利, 薛坤, 等. 大型湖库滨岸带蓝藻水华堆积风险评估——以巢湖为例[J]. 湖泊科学, 2022, 34(1): 49-60. doi: 10.18307/2022.0103 [27] 张松兰. 基于卷积神经网络的图像识别综述[J]. 西安航空学院学报, 2023, 41(1): 74-81. [28] 李炳臻, 刘克, 顾佼佼, 等. 卷积神经网络研究综述[J]. 计算机时代, 2021(4): 8-12,17. [29] RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation[C]//Proceedings of International Conference on Medical Image Computing and Computer-Assisted Intervention. Heidelberg: Springer, 2015: 234-241. [30] DU G T, XU C, LIANG J M, et al. Medical Image Segmentation based on U-Net: A Review[J]. Journal of Imaging Science and Technology, 2020, 64(2): 20508.1-20508.12. doi: 10.2352/J.ImagingSci.Technol.2020.64.2.020508 [31] SIMONYAN K, ZISSERMAN A. Very Deep convolutional networks for large-scale image recognition[C]//International Conference on Learning Representations (ICLR). 2015: 1-14. [32] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 40(4): 834-848. [33] 陈辉, 张傲, 孙帅, 等. 基于改进DeepLabv3+的含噪声热红外图像光伏热斑检测方法[J]. 太阳能学报, 2023, 44(11): 23-30. [34] 谢宗武, 马博宇, 蒋再男, 等. 面向空间机械臂遥操作的虚拟相机成像技术[J]. 哈尔滨工程大学学报, 2023, 44(4): 631-638. [35] 马颂德, 张正友. 计算机视觉: 计算理论与算法基础[M]. 北京: 科学出版社, 1998. [36] 张宇, 张春燕, 陈笋. 基于OpenCV的视频图像梯形畸变实时校正方法[J]. 合肥学院学报(自然科学版), 2013, 23(3): 43-47. [37] 景庄伟, 管海燕, 臧玉府, 等. 基于深度学习的点云语义分割研究综述[J]. 计算机科学与探索, 2021, 15(1): 1-26. doi: 10.3778/j.issn.1673-9418.2006025 [38] RUSSELL B C, TORRALBA A, MURPHY K P, et al. LabelMe: A Database and Web-Based Tool for Image Annotation[J]. International Journal of Computer Vision, 2008, 77(1/2/3). [39] PASZKE A, GROSS S, MASSA F, et al. Pytorch: An imperative style, high-performance deep learning library[C] //Proceedings of the Advances in Neural Information Processing Systems. Vancouver, Canada, 2019: 8024-8035. [40] 罗会兰, 张云. 基于深度网络的图像语义分割综述[J]. 电子学报, 2019, 47(10): 2211-2220. doi: 10.3969/j.issn.0372-2112.2019.10.024 -

下载:

下载: